金磊 发自 凹非寺

量子位 | 公众号 QbitAI

超大限度MoE模子(如DeepSeek),到底该若何推理才能作念到又快又稳。

刻下,这个问题似乎还是有了圭臬谜底——

华为一个新方法,径直把推理超大限度MoE背后的架构、期间和代码,都备给开源了!

这个新开源方法名叫Omni-Infer,全体来看,它关于企业用户来说曲直常利好的。

举例它不错给企业提供PD辞别部署决策,针对QPM进行系统级优化,还会共享大限度商用流程中硬件使用的“步调论”。

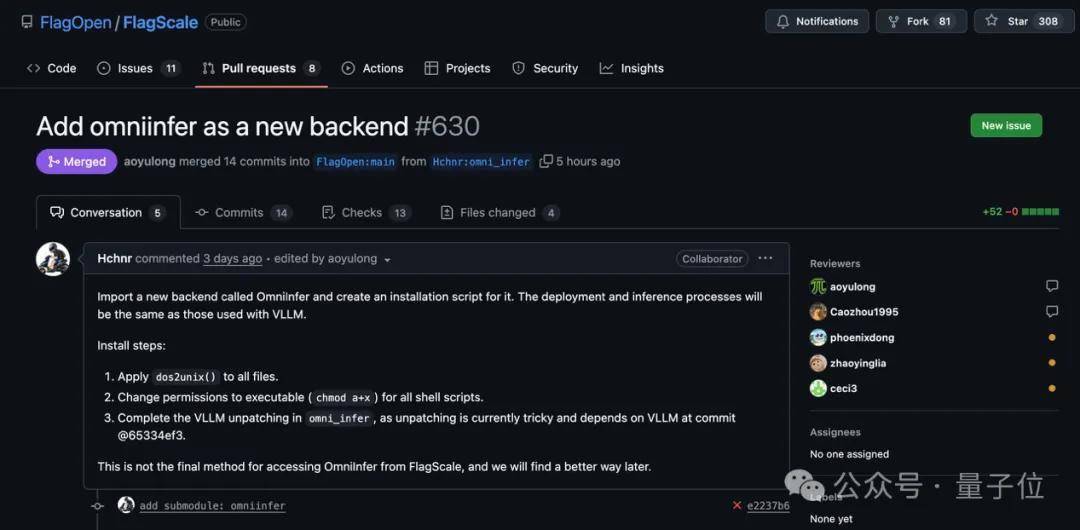

而且关于诱导者和开源社区,华为这“一呼”亦然起到了“百应”的后果。

北京智源研究院副院长兼总工程师林咏华暗意:

北京智源研究院一直以来死力于东说念主工智能开源生态确立,很骄气看到Omni-infer方法开源,智源团队打造的面向多芯片的FlagScale框架也在第一时期接入了Omni-infer,期待后续有更多生态合作。

GitHub地址:https://github.com/FlagOpen/FlagScale/pull/630

上海东说念主工智能实验室系统平台中心细致东说念主王辉合计:

DeepLlink死力于打造最怒放兼容的东说念主工智能筹谋体系,相等期待能与Omni-infer方法联袂,茁壮自主软硬件协同开源社区、拓展生态疆土。

以及OpenI启智社区运营中心主任余跃也给出了反映:

OpenI启智社区坚握编削为本,面向以前与Omni-Infer方法一说念打造基于算力网的开源共创迷惑生态。

据了解,华为Omni-Infer社区的定位是 “加快套件+最好扩充”,以前提供开箱即用智力,援助昇腾推理集群快速部署。

而关于这次Omni-Infer的开源,其实是华为完了了一个月前在发布重磅期间发扬之际所作念出的应许。

![]()

那么接下来,咱们就来一同真切了解一下华为的Omni-Infer。

一个框架和一个套件

从全体来看,Omni-Infer不错拆成两大块来看:一个是推理框架,一个是推理加快套件。

![]()

从框架角度来看,Omni-Infer能和业界主流的开源大模子推理框架(如vLLM)无缺兼容,就像不同品牌的零件不错拼装在归拢台机器上。

何况据了解,它的功能还将不断膨大,会握续为昇腾硬件平台上的大模子推理提供更纷乱的援助(举例SGLang等主流开源LLM推理框架)。

值得一提的是,Omni-Infer是与vLLM/SGLang等等这些主流大模子推理开源框架是解耦的,独处装配。

这就意味着用户只需钦慕vLLM等的主版块即可,大大镌汰了软件版块钦慕的老本。

至于Omni-Infer的加快套件,如果用较为形象的比方,它的“掀开方式”是这么的:

企业级的 “诊疗员”:它有一套智能的诊疗系统,就像交通巡警携带车辆一样,能合理安排任务(xPyD诊疗)。而且援助大限度散布式部署,就像多个交通岗位协同责任,岂论任务量多大,都能保证最低的延长,让反映更实时。精确的 “负载均衡器”:关于不同长度的任务序列,它在预填充息争码这两个要道阶段都作念了优化。比如,就像快递分拣中心针对不同大小的包裹剿袭不同的分拣计策,让通盘处理流程的浑沌量达到最大,同期还能保握低延长。MoE模子的 “专属搭档”:它对夹杂众人(MoE)模子止境友好,援助EP144/EP288等多种成就。不错思象成一个大型的 “众人团队”,每个众人细致不同的任务,它能让这些众人高效迷惑。智能的 “资源分派者”:具备分层非均匀冗余和近实时动态众人甩掉功能。就像在一个大型工场里,笔据实时的出产需求,动态调整各个出产线的工东说念主分派,让资源得回最充分的期骗。闪耀光机制的 “强化器”:挑升为LLM、MLLM和MoE等模子优化了闪耀光机制。这就好比给模子的 “闪耀光” 装上了 “放大镜”,让它在处理信息时更聚焦、更高效,进步了模子的性能和可膨大性。如何“食用”?

在聊完Omni-Infer的脾性之后,咱们不绝来看下该如何去体验。

最初关于它的使用环境是有一定的条件:

硬件:刻下仅援助CloudMatrix384推理卡操作系统:Linux Python: >=3.9, <= 3.11

其次在装配方式上,刻下仅援助通过Docker镜像方式进行装配:

docker pull swr.cn-southwest-2.myhuaweicloud.com/omni-ai/omniinfer:202506272026

这个镜像已事先集成所需的CANN及Torch-NPU依赖包,同期内置可径直初始的Omni-Infer与vLLM器用包,开箱即可使用。

不错使用底下这个敕令查抄是否可用:

pip list | grep omni_infer

以PD辞别自动化部署(4机2P1D)为例,它的部署框架如下所示:

![]()

再接下来,只需文档教程,仅极少代码和才能,即可完成装配和部署:

![]()

全体来看,这次华为面向超大限度MoE开源的方法,是作念到了简便几步就不错让AI推理这事变得又快又稳。

极致开源

Omni-Infer除了将此前《华为昇腾工作器 DeepSeek V3/R1 推理部署最好扩充》期间发扬中的要道期间开源出来以外,也同步进行了愈加专科的开源社区确立。

最初,在独处的社区仓库中,将社区责罚、社区会议、社区行为、生态合作、代码法式、诡计文档等社区信息全部怒放出来,让路发者约略最径直真切的参与到社区发展中。

其次,参照业界主流大型开源社区的最好扩充,剿袭怒放的社区责罚机制,通过方法经管委员会(Project Management Committee)和止境趣味小组(Special Interest Group)两级机制,提供自制透明的研究与决策机制。

再次,针对业界同类开源方法大多存在的“一头热”的“被迫适配”生态合作模式问题,Omni-Infer社区则剿袭了“主动适配”的社区构筑旅途,尤其是主动拥抱国内正在逍遥成长的东说念主工智能开源方法,让生态果然实现多方共赢。

当作永远与业界几大主流开源基金会(Linux基金会、OpenInfra基金会、Apache基金会等)保握致密合作有计划的社区团队,Omni-infer刚开源的首个行为就将参与OpenInfra基金会在苏州的Meetup,感趣味的同学不错到现场一样,也顺道可干涉有特色的人人性开源社区的生辰行为。

![]()

终末,扫数关联的地址放底下了,感趣味的小伙伴可自取哦~

期间发扬及可分析代码包:https://gitcode.com/ascend-tribe/ascend-inference-cluster

源代码诱导迷惑:https://gitee.com/omniai/omniinfer

社区责罚、运作等推行:https://gitee.com/omniai/community

【其他托管平台】

Github:https://github.com/omni-ai-npu/omni-infer

OpenI启智社区:https://git.openi.org.cn/omni-ai/omni-infer

GitLink确乎平台:https://gitlink.org.cn/omni-ai/omniinfer

— 完 —

量子位 QbitAI · 头条号

怜惜咱们开yun体育网,第一时期获知前沿科技动态